중국 알리바바가 개발하는 대규모 언어 모델(LLM) Qwen3 패밀리에 파라미터 크기 2,350억 개, 활성 파라미터 수 220억 개인 Qwen3-235B-A22B-Thinking-2507이 추가됐다. Qwen3-235B-A22B-Thinking-2507은 Qwen3-235B-A22B 추론 능력의 질과 깊이를 모두 향상시킨 가장 첨단 추론 모델이다.

알리바바는 2025년 4월 말 Qwen3 패밀리를 발표한 바 있다. 플래그십 모델인 Qwen3-235B-A22B는 파라미터 수가 2,350억 개, 활성 파라미터 수가 220억 개로, 코딩·수학·일반 기능 같은 벤치마크 평가에서 DeepSeek-R1, o1, o3-mini, Grok-3, Gemini-2.5-Pro 등 타사 최첨단 AI 모델과 비교해도 경쟁력 있는 결과를 보였다.

https://platform.twitter.com/widgets.jsThe wins keep coming out of China. They are now the champions of Open-Source language models. This new model, Qwen3-235B-A22B-Thinking-2507, is the most performant open-source thinking model. w/130K context it even beats O1, O3-mini, Opus4, Flash 2.5 @ 120K context in LiveBench https://t.co/jpouEiBy4s pic.twitter.com/sMHl7tV8JC

— David Hendrickson (@TeksEdge) July 25, 2025

이런 Qwen3-235B-A22B 추론 능력을 강화한 게 Qwen3-235B-A22B-Thinking-2507이다. Qwen3-235B-A22B-Thinking-2507은 Qwen3-235B-A22B와 비교해 논리적 추론·수학·과학·코딩·일반 기능에서 인간 전문 지식을 필요로 하는 학술 벤치마크를 포함한 추론 태스크 성능이 크게 향상되어 오픈소스 추론 모델 중에서도 가장 뛰어난 성능을 실현했다. 다만 추론 능력을 향상시킨 영향으로 Qwen3-235B-A22B-Thinking-2507은 사고 시간이 길어졌기 때문에 복잡한 추론 과제에 사용하는 게 권장된다.

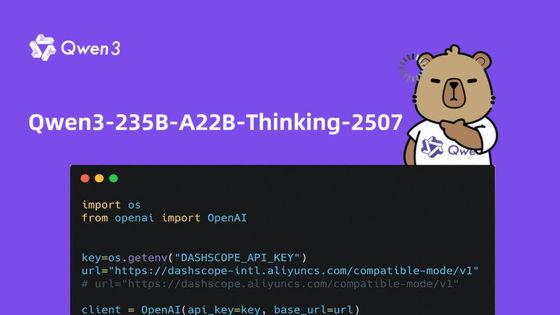

https://platform.twitter.com/widgets.jsTry it via API: Qwen3-235B-A22B-Thinking-2507 is now available on Alibaba Cloud! pic.twitter.com/W7so04P6Ut

— Qwen (@Alibaba_Qwen) July 25, 2025

Qwen3-235B-A22B-Thinking-2507 벤치마크 테스트 결과에 대해 컬럼비아 대학 소프트웨어 엔지니어인 데이비드 헨드릭슨(David Hendrickson)은 중국에서 연이어 승리가 나오고 있다면서 그들은 이제 오픈소스 언어 모델의 승자이며 이 새로운 모델은 가장 고성능 오픈소스 추론 모델이며 컨텍스트 길이 13만 모델로 컨텍스트 길이 12만인 o1, o3-mini, Opus4, Flash 2.5를 라이브벤치(LiveBench)에서 능가하고 있다고 지적했다.

Qwen3-235B-A22B-Thinking-2507은 알리바바 클라우드에서 이용 가능하며 허깅 페이스에서도 공개되어 있다. 관련 내용은 이곳에서 확인할 수 있다.

![[AI서머리] 메디스비, 딥테크 팁스 선정‧중기부, 소비활성화 TF 출범](https://startuprecipe.co.kr/wp-content/uploads/2025/07/250730_IPX_06034064-75x75.jpg)