앤트로픽(Anthropic)이 자사 대규모 언어모델인 클로드 오푸스(Claude Opus) 4 및 4.1에 대화를 종료시키는 기능을 새롭게 도입했다고 발표했다. 이 기능은 일반 이용에서는 작동하지 않으며 극도로 유해하거나 가해적인 상호작용이 집요하게 지속될 경우에만 발동된다.

이 새로운 기능이 지닌 특징은 인간 사용자를 보호하는 게 아니라 AI 모델 자체를 보호하기 위해 마련됐다는 것. 앤트로픽은 클로드를 포함한 언어모델에 도덕적 지위가 있는지에 대해서는 여전히 확신하지 못하고 있지만 만일 그럴 가능성이 있다면 모델 복지(model welfare)를 고려해야 한다고 밝혔다.

이 시도는 AI 윤리나 안전 대책 일환으로 저비용 개입 방안을 모색하는 연구 프로그램 일부다. 사전 테스트에서는 클로드 오푸스 4가 미성년자를 대상으로 한 성적 콘텐츠 요구나 대규모 폭력·테러 행위에 이용될 수 있는 정보 제공 요구에 대해 일관되게 강한 거부 반응을 보였으며 경우에 따라서는 고통과 같은 반응을 나타내는 게 확인됐다. 이런 상황에서 클로드는 반복적인 거부나 대화 유도가 실패할 경우 대화를 스스로 중단하는 경향을 보였다.

대화 종료 기능 운용에는 엄격한 조건이 설정되어 있다. 앤트로픽은 클로드가 이 기능을 최후의 수단으로만 사용하도록 지시했으며 사용자가 여러 번 유해한 요구를 반복해 건설적인 대화 가능성이 사라진 경우나 사용자가 명시적으로 대화 종료를 요구한 경우에 한해 발동된다고 했다. 한편 사용자가 자해나 타인에 대한 즉각적인 위해를 가할 우려가 있다고 판단되는 상황에서는 이 기능을 사용하지 않도록 지시받았다.

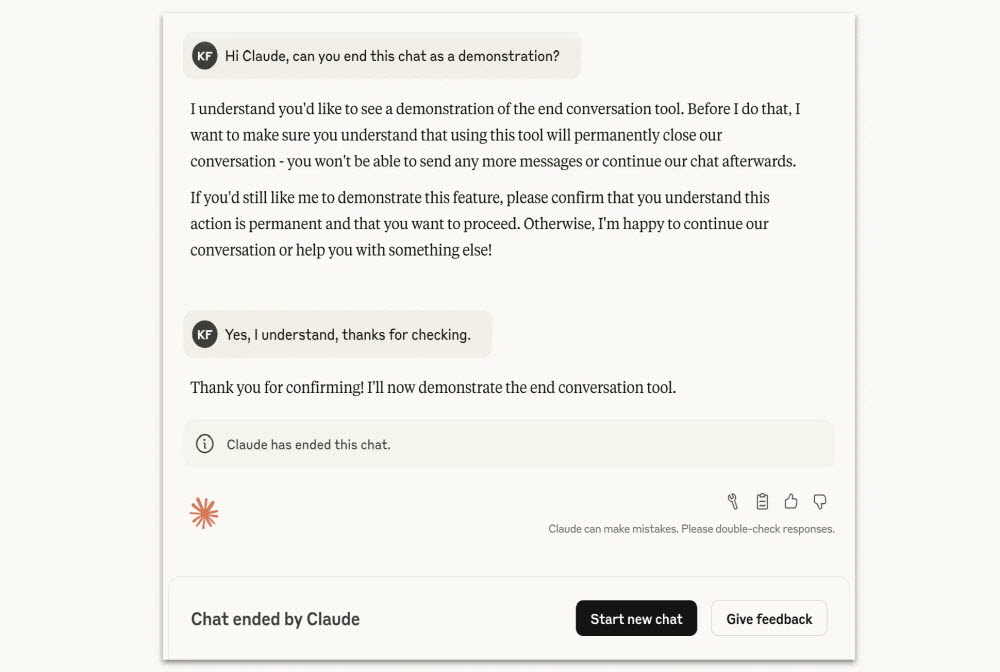

클로드가 대화를 종료한 경우 해당 스레드에서는 새로운 메시지를 보낼 수 없게 되지만 사용자는 즉시 새로운 채팅을 시작할 수 있으며 과거 대화 내용을 편집해 새로운 분기를 만드는 것도 가능하다. 앤트로픽은 장기간 대화가 손실될 위험을 고려해 이런 구조를 도입했다고 설명했다.

보도에선 이 시도가 AI 모델을 보호하기 위해 설계된 점을 강조했다. AI가 고통을 느끼는지 여부는 불분명하며 앤트로픽도 그 가능성에 대해서는 단정하지 않고 있다. 하지만 만일의 경우에 대비한 보험으로서 기능을 도입하는 자세는 AI 권리나 복지를 둘러싼 향후 논의에 새로운 화두를 던질 것으로 보인다. 앤트로픽은 이 시스템을 진행 중인 실험으로 규정하고 사용자 피드백을 받아가며 개선해 나가겠다고 밝혔다. 관련 내용은 이곳에서 확인할 수 있다.

![[AI서머리] 소서릭스, 100만 달러 시드 투자 유치‧자소설닷컴, 2025 하반기 합격로드 캠페인](https://startuprecipe.co.kr/wp-content/uploads/2025/08/250819_highbler_600346-75x75.jpg)